Hbase安装

第五节 Hbase安装

主节点安装 hbase

安装 hbase

1

2cd /usr/app

wget https://archive.apache.org/dist/hbase/1.2.6/hbase-1.2.6-bin.tar.gz解压

1

tar –zxvf hbase-1.2.6-bin.tar.gz

配置 hbase 集群

把 hadoop 的 hdfs-site.xml 和 core-site.xml 放到 hbase/conf

修改 环境变量

1

2

3

4

5Vi /etc/profileexport JAVA_HOME=/usr/app/jdk1.8.0_77

export HADOOP_HOME=/usr/app/hadoop-2.7.3

export HBASE_HOME=/usr/app/hbase-1.2.6

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HBASE_HOME/bin

# 注意:source /etc/profile (刷新环境变量配置文件)1

2

3

4# 修改 hbase-env.sh /usr/app/hbase-1.2.6/conf/

export JAVA_HOME= /usr/app/jdk1.8.0_77

# hbase 使用外部的 zk,hbase自带的zk只可用于伪分布式

export HBASE_MANAGES_ZK=false

修改 hbase-site.xml 配置

1

vim hbase-site.xml

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21<configuration>

<!-- 指定 hbase 在 HDFS 上存储的路径 -->

<property>

<name>hbase.rootdir</name>

<value>hdfs://ns1/hbase</value>

</property>

<!-- 指定 hbase 是分布式的 -->

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

<property>

<name>hbase.master.info.port</name>

<value>60010</value>

</property>

</property>

<!-- 指定 zk 的地址,多个用“,”分割 -->

<property>

<name>hbase.zookeeper.quorum</name>

<value>hadoop11:2181,hadoop12:2181,hadoop13:2181</value>

</property>

</configuration>增加 slave 的集群

1

Vim /usr/app/hbase-1.2.6/conf/regionservers

1

2

3

4# (部署到 datanode 上面,那一台启动 hbase 那一台就是 master)

hadoop11

hadoop12

hadoop13拷贝 hbase 到其他节点

1

2scp -r /usr/app/hbase-1.2.6 root@hadoop12:/usr/app/

scp -r /usr/app/hbase-1.2.6 root@hadoop13:/usr/app/启动所有的 hbase

1

2

3

4

5

6

7# 前提需要:Zookeeper 和 Hdfs 启动

# 分别启动 zk

./zkServer.sh start

# 启动 hbase 集群

start-dfs.sh

# 启动 hbase,在主节点上运行:

/usr/app/hbase-1.2.6/bin/start-hbase.sh

通过浏览器访问 hbase 管理页面

1

http://192.168.200.11:16010/master-status

为保证集群的可靠性,要启动多个 HMaster

1 | hbase-daemon.sh start master |

HBase Shell命令行操作

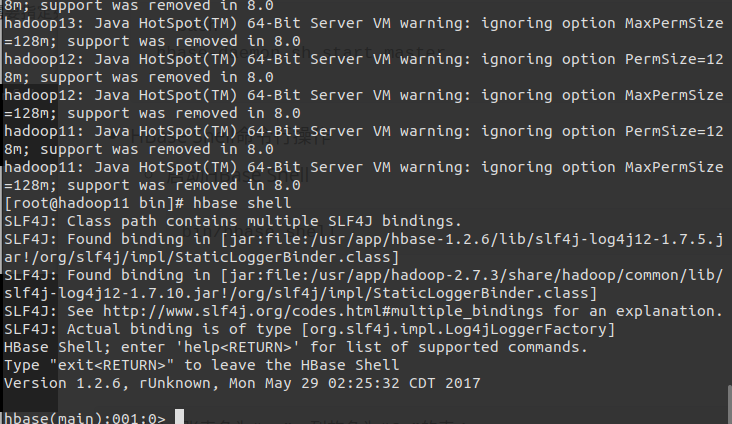

启动HBase Shell

1

bin/hbase shell

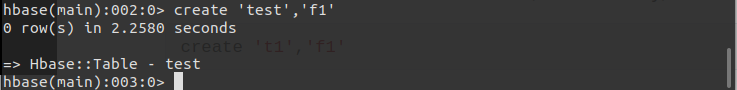

创建表,需要创建表明,另外需要指定列簇(column family)。表名和列簇名都需要使用引号括起来。

1

create 'test','f1'

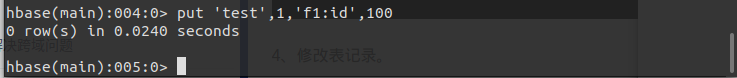

向表中加入数据。这里使用关键字put。

1

put 'test',1,'f1:id',100

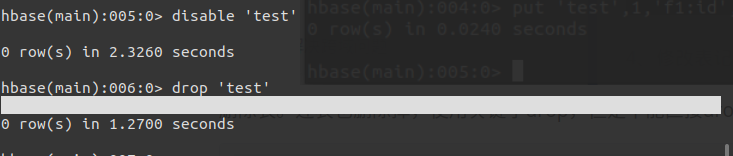

- 删除表。连表也删除掉,使用关键字drop,但是不能直接drop,在drop之前需要先disable。

disable 'test'

drop 'test'

至此,Hbase安装完成 下节MYSQL安装

# 相关文章

1.spark安装

2.VMware16安装_Ubuntu

3.scala安装

4.Centos7 安装

5.Zookeeper安装

6.Hadoop2.7 安装

7.主节点安装 Hive

8.主节点安装 MySql

1.spark安装

2.VMware16安装_Ubuntu

3.scala安装

4.Centos7 安装

5.Zookeeper安装

6.Hadoop2.7 安装

7.主节点安装 Hive

8.主节点安装 MySql

此处评论已关,暂不支持评论。