主节点安装 Hive

第七节 主节点安装 Hive

上传压缩包,解压

1

wget https://archive.apache.org/dist/hive/hive-0.12.0/hive-0.12.0-bin.tar.gz

安装 mysql 服务器(见上一节)

配置环境变量

1

2

3

4

5

6vi /etc/profile

export JAVA_HOME=/usr/app/jdk1.8.0_77

export HADOOP_HOME=/usr/app/hadoop-2.7.3

export HBASE_HOME=/usr/app/hbase-1.2.6

export HIVE_HOME=/usr/app/hive-0.12.0

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HBASE_HOME/bin:$HIVE_HOME/bin进入 hive 的 conf 目录新建一个 hive-site.xml

1

2cd /usr/app/hive-0.12.0/

touch hive-site.xml在 hive-site.xml 中写入 mysql 连接信息

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30<configuration>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://hadoop11:3306/hive?createDatabaseIfNotExist=true</value>

<description>JDBC connect string for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>Driver class name for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

<description>username to use against metastore database</description>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

<description>password to use against metastore database</description>

</property>

<property>

<name>hive.server2.thrift.sasl.qop</name>

<value>auth</value>

</property>

<property>

<name>hive.metastore.schema.verification</name>

<value>false</value>

</property>

</configuration>将 mysql 的驱动包复制到 hive 的 lib 目录下 app/hive-0.12.0/lib

修改/usr/app/hive-0.12.0/conf/hive-env.sh

1

2

3

4# 增加以下内容

export JAVA_HOME=/usr/app/jdk1.8.0_77

export HADOOP_HOME=/usr/app/hadoop-2.7.3

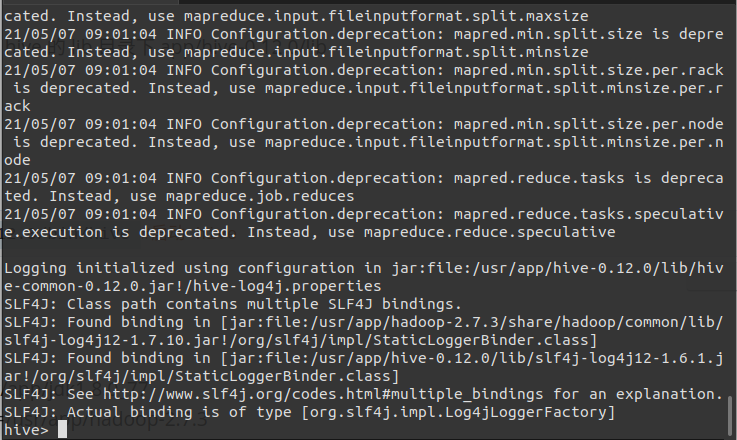

export HBASE_HOME=/usr/app/hbase-1.2.6验证hive安装

1

2

3

4

5

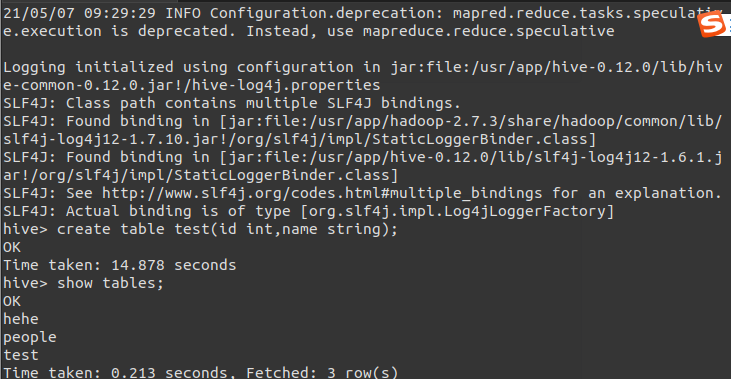

6Sh /usr/app/hive-0.12.0/bin/hive #启动 hive

hive> create table test(id int,name string);

hive> show tables;

[root@hadoop11 ~]# hadoop fs -lsr /

下节 flume安装

# 相关文章

1.VMware16安装_Ubuntu

2.scala安装

3.spark安装

4.Centos7 安装

5.Hadoop2.7 安装

6.Zookeeper安装

7.Hbase安装

8.主节点安装 MySql

1.VMware16安装_Ubuntu

2.scala安装

3.spark安装

4.Centos7 安装

5.Hadoop2.7 安装

6.Zookeeper安装

7.Hbase安装

8.主节点安装 MySql