Zookeeper安装

第四节 Zookeeper安装

zookeeper 安装

下载zookeeper

1

2cd /usr/app

wget https://archive.apache.org/dist/zookeeper/zookeeper-3.4.8/zookeeper-3.4.8.tar.gz解压

1

tar -zxvf zookeeper-3.4.8.tar.gz

配置(先在一台节点上配置)

添加一个 zoo.cfg 配置文件

1

2cd zookeeper-3.4.8/conf/

cp -r zoo_sample.cfg zoo.cfg

修改配置文件(zoo.cfg)

1

2# 建立/usr/app/zookeeper-3.4.8/data 目录,

mkdir /usr/app/zookeeper-3.4.8/data配置 zoo.cfg

1

2

3

4

5dataDir=/usr/app/zookeeper-3.4.8/data

#在最后一行添加

server.1=hadoop11:2888:3888

server.2=hadoop12:2888:3888

server.3=hadoop13:2888:3888创建一个 myid 文件,

1

2

3

4

5cd /usr/app/zookeeper-3.4.8/data

touch myid

vi myid

echo "1" >myid

#里面内容是 server.N 中的 N(server.2 里面内容为 2)拷贝

1

2

3

4

5

6# 将配置好的 zk 拷贝到其他节点

scp -r /usr/app/zookeeper-3.4.8/root@hadoop12:/usr/app

scp -r /usr/app/zookeeper-3.4.8/root@hadoop13:/usr/app

# 注意:在其他节点上一定要修改 myid 的内容

# 在 hadoop12 应该讲 myid 的内容改为 2 (echo "2" >myid)

# 在 hadoop13 应该讲 myid 的内容改为 3 (echo "3" >myid)启动集群

1

2

3

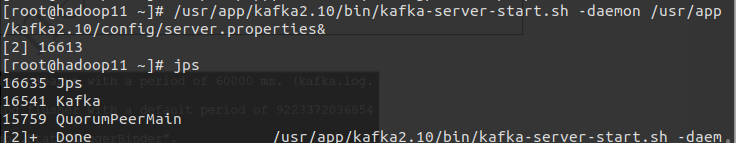

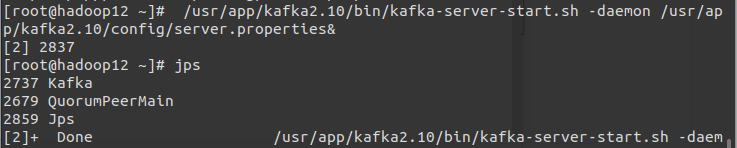

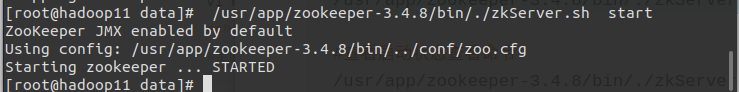

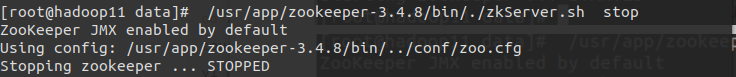

4# Zookeeper 启动及关闭命令

/usr/app/zookeeper-3.4.8/bin/./zkServer.sh start

/usr/app/zookeeper-3.4.8/bin/./zkServer.sh stop

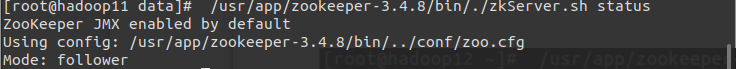

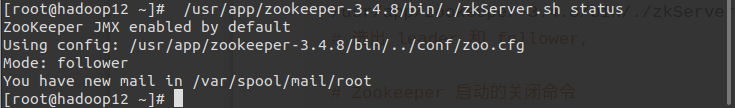

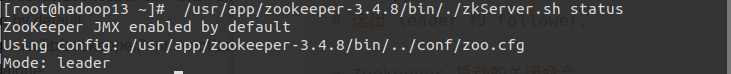

# 选出 leader 和 follower,

1

2#查看启动状态查看命令

/usr/app/zookeeper-3.4.8/bin/./zkServer.sh status

至此,Zookeeper安装完成 下节Hbase安装